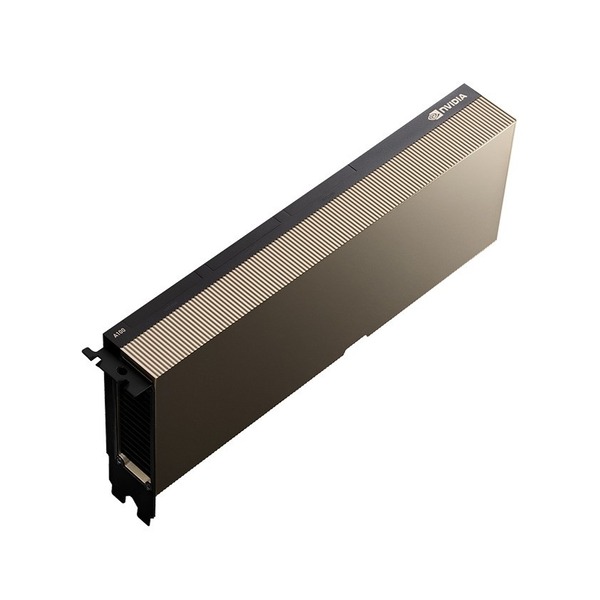

کارت گرافیک انویدیا NVIDIA A100 Tensor CoreNVIDIA A100 Tensor Core GPU

- قدرتمندترین پلتفرم محاسباتی برای هر بار کاری

- فناوری Tensor Core و Multi-Instance GPU (MIG)

- هستههای Tensor نسل سوم

- فناوری NVLink نسل جدید

- حافظه با پهنای باند بالا (HBM2E)

برای مشاوره و خرید تماس بگیرید

021-29700

کارت گرافیک NVIDIA A100 Tensor Core: شتابی بیسابقه در هر مقیاس

قدرتمندترین پلتفرم محاسباتی برای هر بار کاری

کارت گرافیک NVIDIA A100 Tensor Core شتابی بینظیر را در هر مقیاسی ارائه میدهد تا مراکز داده انعطافپذیر را برای پردازشهای هوش مصنوعی، تحلیل دادهها و محاسبات با کارایی بالا (HPC) تقویت کند. بهعنوان موتور اصلی پلتفرم مرکز داده NVIDIA، A100 تا 20 برابر عملکرد بیشتری نسبت به نسل قبلی NVIDIA Volta فراهم میکند. A100 میتواند بهصورت پویا مقیاسپذیر باشد و به لطف قابلیت Multi-Instance GPU (MIG) به هفت بخش GPU مجزا تقسیم شود. این ویژگی امکان انطباق مراکز داده را با تغییرات بار کاری بهراحتی فراهم میآورد.

فناوری Tensor Core در NVIDIA A100 از انواع دقتهای محاسباتی پشتیبانی میکند و بهعنوان شتابدهندهای چندمنظوره برای انواع بارهای کاری عمل میکند. مدل 80 گیگابایتی A100، با افزایش دو برابری حافظه و ارائه سریعترین پهنای باند حافظه جهان با سرعت 2 ترابایت بر ثانیه، زمان مورد نیاز برای پردازش مدلها و مجموعه دادههای بزرگ را بهطور چشمگیری کاهش میدهد.

A100 بخشی از راهحل جامع NVIDIA برای مراکز داده است که سختافزار، شبکه، نرمافزار، کتابخانهها و مدلها و برنامههای بهینهسازیشده از کاتالوگ NVIDIA NGC را شامل میشود. این پلتفرم قدرتمند هوش مصنوعی و HPC به محققان امکان میدهد تا نتایج عملی ارائه کرده و راهحلهای خود را در مقیاس بزرگ بهکار گیرند.

نوآوریهای شگفتانگیز

معماری NVIDIA Ampere

از ویژگیهای مقیاسپذیر A100 میتوان به تقسیم GPU به واحدهای کوچکتر با MIG یا اتصال چندین GPU با NVLink برای تسریع بارهای کاری بزرگ اشاره کرد. این کارت برای نیازهای مختلف پردازشی از کوچکترین تا بزرگترین بارهای کاری قابلاستفاده است و مدیران فناوری اطلاعات میتوانند بهینهترین بهرهوری را از هر GPU موجود در مرکز داده خود ببرند.

هستههای Tensor نسل سوم

کارت NVIDIA A100 با 312 ترافلاپ عملکردی در یادگیری عمیق، توان محاسباتی فوقالعادهای ارائه میدهد. این عملکرد 20 برابر بیشتر از نسل قبلی Volta است، چه در آموزش مدلها و چه در استنتاج.

NVLink نسل جدید

فناوری NVLink در A100 دو برابر throughput نسل قبلی را ارائه میدهد. همراه با NVSwitch™ NVIDIA، میتوان تا 16 کارت A100 را با حداکثر سرعت 600 گیگابایت بر ثانیه متصل کرد که این امر بیشترین کارایی برنامهها در یک سرور واحد را ممکن میسازد. NVLink برای کارتهای A100 SXM از طریق سرورهای HGX A100 و در کارتهای PCIe از طریق پل NVLink برای اتصال حداکثر دو GPU در دسترس است.

حافظه با پهنای باند بالا (HBM2E)

با تا 80 گیگابایت حافظه HBM2E، A100 سریعترین پهنای باند حافظه GPU جهان را با بیش از 2 ترابایت بر ثانیه ارائه میدهد و به راندمان 95 درصد در استفاده از DRAM دست مییابد. A100 تا 1.7 برابر پهنای باند بیشتری نسبت به نسل قبلی خود دارد.

قابلیت Multi-Instance GPU (MIG)

کارت A100 میتواند به هفت واحد GPU مجزا تقسیم شود که هر کدام با حافظه پرسرعت، کش و هستههای پردازشی مستقل خود از دیگر واحدها جدا شدهاند. این ویژگی، شتابدهی انقلابی را برای همه برنامهها فراهم کرده و به مدیران فناوری اطلاعات امکان میدهد تا GPUها را بهطور بهینه و برای هر وظیفه مناسب تنظیم کنند و دسترسی به GPU را برای هر کاربر و برنامه گسترش دهند.

کاهش پارامترهای ساختاری

شبکههای هوش مصنوعی دارای میلیونها تا میلیاردها پارامتر هستند، اما بسیاری از این پارامترها برای پیشبینی دقیق ضروری نیستند و میتوان برخی از آنها را بدون افت دقت به صفر تبدیل کرد تا مدلها “پراکنده” شوند. هستههای Tensor در A100 میتوانند عملکرد مدلهای پراکنده را تا دو برابر افزایش دهند. این ویژگی که بهطور خاص در استنتاج هوش مصنوعی مفید است، میتواند عملکرد آموزش مدلها را نیز بهبود دهد.

کارت NVIDIA A100 Tensor Core GPU محصول شاخص پلتفرم مرکز داده NVIDIA برای یادگیری عمیق، HPC و تحلیل داده است. این پلتفرم بیش از 2000 برنامه از جمله تمامی چارچوبهای اصلی یادگیری عمیق را شتاب میبخشد. A100 از سرورها و فضای ابری گرفته تا دسکتاپها در دسترس است و علاوه بر افزایش چشمگیر عملکرد، امکان صرفهجویی قابل توجه در هزینهها را نیز فراهم میکند.

مشخصات فنی

| A100 80GB PCIe | A100 80GB SXM | |

|---|---|---|

| FP64 | 9.7 TFLOPS | |

| FP64 Tensor Core | 19.5 TFLOPS | |

| FP32 | 19.5 TFLOPS | |

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS | |

| BFLOAT16 Tensor Core | 312 TFLOPS | 624 TFLOPS | |

| FP16 Tensor Core | 312 TFLOPS | 624 TFLOPS | |

| INT8 Tensor Core | 624 TOPS | 1248 TOPS | |

| Multi-Instance GPU | Up to 7 MIGs @ 10GB | |

| GPU Memory | 80GB HBM2e | |

| GPU Memory Bandwitdh | 1,935GB/s | 2,039GB/s |

| Max Thermal Design Power (TDP) | 300W | 400W |

| Form Factor | PCIe dual-slot air cooled or single-slot liquid cooled |

SXM |

| Interconnect | NVIDIA NVLink Bridge for 2 GPUs: 600GB/s PCIe Gen4: 64GB/s |

NVLink: 600GB/s PCIe Gen4: 64GB/s |

| Server Options | Partner and NVIDIA- Certified Systems with 1-8 GPUs |

NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

لطفا پیش از ارسال نظر، خلاصه قوانین زیر را مطالعه کنید:

فارسی بنویسید و از کیبورد فارسی استفاده کنید. بهتر است از فضای خالی (Space) بیشازحدِ معمول، شکلک یا ایموجی استفاده نکنید و از کشیدن حروف یا کلمات با صفحهکلید بپرهیزید.

نظرات خود را براساس تجربه و استفادهی عملی و با دقت به نکات فنی ارسال کنید؛ بدون تعصب به محصول خاص، مزایا و معایب را بازگو کنید و بهتر است از ارسال نظرات چندکلمهای خودداری کنید.

بهتر است در نظرات خود از تمرکز روی عناصر متغیر مثل قیمت، پرهیز کنید.

به کاربران و سایر اشخاص احترام بگذارید. پیامهایی که شامل محتوای توهینآمیز و کلمات نامناسب باشند، حذف میشوند.

نقد و بررسیها0

هنوز بررسیای ثبت نشده است.