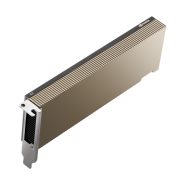

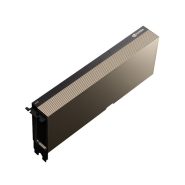

کارت گرافیک انویدیا NVIDIA H100 Tensor CoreNVIDIA H100 Tensor Core GPU

- شتابدهی ایمن از مراکز داده سازمانی تا مقیاس Exascale

- نوآوریهای معماری NVIDIA Hopper

- سیستم سوئیچ NVLink

- Multi-Instance GPU (MIG) نسل دوم

- پیشرفتی چشمگیر در محاسبات شتابیافته

برای مشاوره و خرید تماس بگیرید

021-29700

کارت گرافیک NVIDIA H100 Tensor Core: عملکرد فوقالعاده، مقیاسپذیری و امنیت بینظیر برای هر مرکز داده

پیشرفتی چشمگیر در محاسبات شتابیافته

کارت NVIDIA H100 Tensor Core GPU عملکرد استثنایی، مقیاسپذیری و امنیت بینظیری را برای هر بار کاری ارائه میدهد. H100 که بر اساس معماری انقلابی NVIDIA Hopper طراحی شده، با شتابدهی 30 برابری مدلهای زبانی بزرگ، هوش مصنوعی مکالمهای پیشرو در صنعت را ارائه میکند.

شتابدهی ایمن از مراکز داده سازمانی تا مقیاس Exascale

کارت H100 مجهز به هستههای Tensor نسل چهارم و موتور Transformer با دقت FP8 است که تا چهار برابر سرعت آموزش مدلهای GPT-3 را نسبت به نسل قبل افزایش میدهد. در برنامههای محاسبات با کارایی بالا (HPC)، H100 تعداد عملیات نقطه شناور در هر ثانیه (FLOPS) را در هستههای Tensor با دقت مضاعف سه برابر کرده و 60 ترافلاپس محاسبات FP64 را برای HPC فراهم میکند و همچنین با دستورالعملهای Dynamic Programming (DPX) عملکرد را تا هفت برابر بهبود میبخشد. با بهرهگیری از قابلیتهای نسل دوم Multi-Instance GPU (MIG)، پردازش محرمانه NVIDIA و سیستم سوئیچ NVLink NVIDIA، کارت H100 با ایمنی کامل بارهای کاری را از مراکز داده سازمانی تا مقیاس اگزاسکیل تسریع میکند.

شتابدهی به استنتاج مدلهای زبانی بزرگ با H100 NVL

برای مدلهای زبانی بزرگ (LLM) تا 70 میلیارد پارامتر، کارت NVIDIA H100 NVL مبتنی بر PCIe به همراه پل NVLink از موتور Transformer، NVLink و 188 گیگابایت حافظه HBM3 استفاده میکند تا بهترین عملکرد و مقیاسپذیری را در مراکز داده ارائه دهد. سرورهای مجهز به GPUهای H100 NVL عملکرد مدل Llama 2 70B را تا پنج برابر بیشتر از سیستمهای NVIDIA A100 افزایش میدهند و این کار را با تأخیر کم و در محیطهای مراکز داده با محدودیت انرژی انجام میدهند.

آماده برای سازمانها: نرمافزار هوش مصنوعی توسعه و استقرار را ساده میکند

NVIDIA H100 NVL همراه با اشتراک پنجساله NVIDIA AI Enterprise عرضه شده و راهاندازی یک پلتفرم هوش مصنوعی آماده برای سازمان را سادهتر میکند. H100 توسعه و استقرار هوش مصنوعی را برای راهحلهای هوش مصنوعی آماده تولید، از جمله بینایی کامپیوتری، هوش مصنوعی گفتاری، بازیابی افزایشیافته (RAG) و دیگر موارد شتاب میدهد. NVIDIA AI Enterprise شامل NVIDIA NIM™ است، مجموعهای از میکروسرویسهای آسان برای تسریع در استقرار هوش مصنوعی مولد سازمانی. این راهکارهای سازمانی شامل امنیت، مدیریتپذیری، پایداری و پشتیبانی در سطح سازمان است که نتیجه آن، راهکارهای بهینهسازی شده هوش مصنوعی با ارزش تجاری سریعتر و بینشهای عملی است.

نوآوریهای معماری NVIDIA Hopper

کارت گرافیک NVIDIA H100 Tensor Core

کارت H100 با 80 میلیارد ترانزیستور و فرآیند TSMC 4N که مختص نیازهای محاسبات شتابیافته NVIDIA سفارشی شده است، ساخته شده و پیشرفتهای بزرگی در تسریع هوش مصنوعی، محاسبات HPC، پهنای باند حافظه، ارتباطات و اتصالات در سطح مراکز داده ایجاد کرده است.

موتور Transformer

موتور Transformer با استفاده از فناوری نرمافزار و هستههای Tensor Hopper برای شتابدهی به آموزش مدلهای ساختهشده از مهمترین معماری هوش مصنوعی یعنی ترنسفورمر طراحی شده است. هستههای Tensor Hopper میتوانند از دقتهای مختلط FP8 و FP16 استفاده کنند تا محاسبات هوش مصنوعی را برای مدلهای ترنسفورمر بهطور چشمگیری تسریع کنند.

سیستم سوئیچ NVLink

سیستم سوئیچ NVLink امکان گسترش ورودی/خروجی (I/O) چند GPU در چندین سرور را با 900 گیگابایت بر ثانیه به ازای هر GPU فراهم میکند که بیش از هفت برابر پهنای باند PCIe Gen5 است. این سیستم 9 برابر پهنای باند بیشتری نسبت به InfiniBand HDR در معماری NVIDIA Ampere ارائه میدهد.

پردازش محرمانه NVIDIA

کارت NVIDIA H100 امنیت بالایی را برای بارهای کاری با نیاز به محرمانگی و یکپارچگی فراهم میکند. محاسبات محرمانه از حفاظت مبتنی بر سختافزار برای دادهها و برنامهها در حال استفاده پشتیبانی میکند.

Multi-Instance GPU (MIG) نسل دوم

معماری Hopper با نسل دوم MIG از پیکربندیهای چندکاربره در محیطهای مجازی پشتیبانی میکند و GPU را به واحدهای جداگانه و مناسب برای هر کاربر تقسیم میکند تا کیفیت خدمات (QoS) را برای هفت برابر کاربران ایمنتر به حداکثر برساند.

دستورالعملهای DPX

دستورالعملهای DPX در Hopper الگوریتمهای برنامهریزی پویا را تا 40 برابر سریعتر از CPUها و 7 برابر سریعتر از GPUهای معماری NVIDIA Ampere تسریع میکنند که منجر به کاهش چشمگیر زمان در تشخیص بیماری، بهینهسازی مسیرهای بلادرنگ و تحلیل گراف میشود.

مشخصات فنی

| H100 SXM | H100 NVL | |

|---|---|---|

| FP64 | 34 teraFLOPS | 30 teraFLOPS |

| FP64 Tensor Core | 67 teraFLOPS | 60 teraFLOPS |

| FP32 | 67 teraFLOPS | 60 teraFLOPS |

| TF32 Tensor Core | 989 teraFLOPS | 835 teraFLOPS |

| BFLOAT16 Tensor Core | 1,979 teraFLOPS | 1,671 teraFLOPS |

| FP16 Tensor Core | 1,979 teraFLOPS | 1,671 teraFLOPS |

| FP8 Tensor Core | 3,958 teraFLOPS | 3,341 teraFLOPS |

| INT8 Tensor Core | 3,958 TOPS | 3,341 TOPS |

| GPU Memory | 80GB | 94GB |

| GPU Memory Bandwitdh | 3.35TB/s | 3.9TB/s |

| Decoders | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| Max Thermal Design Power (TDP) | Up to 700W (configurable) |

350-400W (configurable) |

| Multi-Instance GPUs | Up to 7 MIGs @ 10GB each | Up to 7 MIGS @ 12GB each |

| Form Factor | SXM | PCIe dual-slot air-cooled |

| Interconnect | NVIDIA NVLink™: 900GB/s PCIe Gen5: 128GB/s |

NVIDIA NVLink: 600GB/s PCIe Gen5: 128GB/s |

| Server Options | NVIDIA HGX H100 Partner and NVIDIA- Certified Systems™ with 4 or 8 GPUs NVIDIA DGX H100 with 8 GPUs |

Partner and NVIDIA- Certified Systems with 1–8 GPUs |

| NVIDIA Enterprise | Add-on | Included |

لطفا پیش از ارسال نظر، خلاصه قوانین زیر را مطالعه کنید:

فارسی بنویسید و از کیبورد فارسی استفاده کنید. بهتر است از فضای خالی (Space) بیشازحدِ معمول، شکلک یا ایموجی استفاده نکنید و از کشیدن حروف یا کلمات با صفحهکلید بپرهیزید.

نظرات خود را براساس تجربه و استفادهی عملی و با دقت به نکات فنی ارسال کنید؛ بدون تعصب به محصول خاص، مزایا و معایب را بازگو کنید و بهتر است از ارسال نظرات چندکلمهای خودداری کنید.

بهتر است در نظرات خود از تمرکز روی عناصر متغیر مثل قیمت، پرهیز کنید.

به کاربران و سایر اشخاص احترام بگذارید. پیامهایی که شامل محتوای توهینآمیز و کلمات نامناسب باشند، حذف میشوند.

نقد و بررسیها0

هنوز بررسیای ثبت نشده است.