بهترین پردازندههای گرافیکی برای هوش مصنوعی و یادگیری عمیق

بهترین پردازندههای گرافیکی برای هوش مصنوعی و یادگیری عمیق

هوش مصنوعی (Artificial Intelligence) و یادگیری عمیق (Deep Learning) به ستونهای اصلی تحول دیجیتال و نوآوری تبدیل شده و شیوه کار بسیاری از صنایع، از تولید گرفته تا خدمات مالی و بهداشت را متحول کردهاند. شرکتهای بزرگ مانند گوگل، مایکروسافت و آمازون، و حتی استارتاپهای کوچکتر، همه به دنبال استفاده از پردازندههای گرافیکی برای اجرای مدلهای پیچیده و بهینهسازی فرآیندهای خود هستند، چرا که این GPUها با توانایی انجام محاسبات سنگین به صورت همزمان، نقش کلیدی در تسریع پردازش مدلهای یادگیری عمیق و هوش مصنوعی ایفا میکنند.

در این مقاله، به بررسی بهترین پردازندههای گرافیکی مناسب برای هوش مصنوعی و یادگیری عمیق در سال 2024 میپردازیم. همچنین علاوه بر معرفی مدلهای برتر، عواملی چون عملکرد، کارایی، حافظه، مصرف انرژی و مقرون به صرفه بودن هر GPU را نیز تحلیل خواهیم کرد تا انتخابی دقیق و هوشمندانه داشته باشید.

اهمیت پردازنده گرافیکی برای هوش مصنوعی و یادگیری عمیق

پردازندههای گرافیکی، به لطف توانایی خود در انجام محاسبات موازی و اجرای همزمان هزاران عملیات، به یکی از ارکان اصلی پروژههای هوش مصنوعی و یادگیری عمیق تبدیل شدهاند، در حالی که پردازندههای مرکزی (CPU) بیشتر برای وظایف عمومی و پردازشهای ترتیبی مورد استفاده قرار می گیرند.

برای مثال، آموزش یک شبکه عصبی عمیق (Deep Neural Network) با CPU ممکن است روزها یا حتی هفتهها طول بکشد؛ با این حال، یک GPU مناسب با کاهش قابل توجه زمان پردازش، در پروژههای تحقیقاتی و تجاری که زمان اجرا اهمیت بالایی دارد، تفاوتی اساسی ایجاد میکند. از دیگر دلایل اهمیت GPUها در این حوزه، توانایی آنها در پردازش حجم عظیمی از دادهها است، چرا که یادگیری عمیق به دادههای بزرگ و متنوع نیاز دارد و بدون یک پردازنده گرافیکی قدرتمند، پردازش این اطلاعات به چالشی جدی تبدیل میشود.

چگونه یک پردازنده گرافیکی مناسب انتخاب کنیم؟

انتخاب یک GPU مناسب برای پروژههای هوش مصنوعی و یادگیری عمیق به عوامل متعددی وابسته است که در ادامه به بررسی دقیق ویژگیهای کلیدی مورد نیاز میپردازیم:

- قدرت پردازش: قدرت پردازش یک GPU تحت تأثیر سه عامل کلیدی قرار دارد: تعداد هستهها، فرکانس کاری و معماری آن. به طور کلی، هرچه تعداد هستهها بیشتر و توان پردازشی بالاتری ارائه شود، پردازنده توانایی بیشتری در اجرای محاسبات پیچیده خواهد داشت. علاوه بر این، معماری GPU نیز نقشی حیاتی در تعیین کارایی آن ایفا میکند. به عنوان مثال، معماریهای پیشرفتهای مانند Hopper و Ampere که در GPUهای شرکت NVIDIA به کار رفتهاند، با ارائه عملکرد بهتر و بهرهوری بالاتر، استفاده بهینهتری از منابع را ممکن ساخته و در نهایت تأثیر قابلتوجهی بر قدرت و کارایی نهایی GPU دارند.

- میزان حافظه (Memory): حافظه، به دلیل نیاز مدلهای پیچیده و دادههای حجیم به حافظههای بزرگ، یکی از مهمترین ویژگیهای GPU برای پردازش مدلهای یادگیری عمیق به شمار میآید؛ چرا که تنها در صورت وجود حافظه کافی، امکان بارگذاری کامل و پردازش آنها فراهم میشود. در همین راستا، حافظههای پیشرفتهای مانند HBM3 و GDDR6 که در مدلهای جدید GPU به کار گرفته شدهاند، نه تنها ظرفیت بیشتری ارائه میدهند، بلکه با افزایش سرعت پردازش، کارایی را به طرز چشمگیری بهبود میبخشند.

- پشتیبانی از فناوری CUDA: یکی دیگر از عوامل مهم در انتخاب GPU، پشتیبانی از فناوری CUDA که به طور اختصاصی برای GPUهای NVIDIA طراحی شده می باشد. به سبب سازگاری این فناوری با فریمورکهای محبوب یادگیری عمیق مانند TensorFlow و PyTorch، توسعهدهندگان میتوانند بهراحتی از امکانات پیشرفته این GPUها برای اجرای مدلهای خود بهرهمند شوند. در نتیجه، این سازگاری نه تنها فرآیند توسعه را سادهتر میکند، بلکه موجب بهبود قابلتوجه کارایی مدلها نیز میشود.

- مصرف انرژی: کنترل مصرف انرژی و عملکرد سیستم خنککننده GPU، به طور مستقیم بر طول عمر و هزینههای پروژه اثر میگذارند. به خصوص GPUهایی که طراحی بهینهای برای مدیریت حرارت دارند، که نه تنها عملکرد پایدارتری ارائه میدهند، بلکه با کاهش مصرف انرژی، هزینههای عملیاتی و نگهداری را در بلندمدت به میزان قابلتوجهی کاهش میدهند. این ویژگی، اهمیت انتخاب GPUهایی با سیستمهای حرارتی پیشرفته را دوچندان میکند.

- قیمت: بودجه پروژه یکی از عوامل کلیدی در انتخاب پردازنده گرافیکی مناسب محسوب میشود. مدلهای پیشرفته معمولاً هزینه بیشتری به همراه دارند و برای پروژههای پیچیده مناسبتر هستند. در مقابل، گزینههای ارزانتر میتوانند پاسخگوی نیازهای پروژههای سبکتر باشند. انتخاب متناسب با نیازها و بودجه، از هدررفت منابع جلوگیری کرده و تصمیمگیری را بهینه میکند.

نکات مهم برای بهینهسازی استفاده از GPU

- انتخاب نرم افزار مناسب: استفاده از نرم افزارهای بهینه سازی شده برای GPU، مانند کتابخانههای CUDA و cuDNN، به اجرای بهتر مدلها کمک میکند.

- بهروزرسانی درایورها: همیشه درایورهای GPU خود را بهروز نگه دارید تا از حداکثر کارایی آن بهره ببرید.

- مدیریت منابع: اگر از چند GPU بهصورت همزمان استفاده میکنید، باید منابع را بهطور بهینه مدیریت کنید تا عملکرد سیستم کاهش نیابد.

- استفاده از سیستمهای خنک کننده: خنک نگه داشتن GPU در هنگام اجرای محاسبات سنگین، به جلوگیری از کاهش عملکرد و افزایش طول عمر آن کمک میکند.

چرا در دنیای امروزی انتخاب پردازنده گرافیکی مناسب امری مهم به شمار میآید؟

سال 2024، با معرفی فناوریهای پیشرفتهای همچون معماریهای Hopper و CDNA2، نقطه عطفی در دنیای GPUها به شمار میآید. این فناوریهای نوین، علاوه بر بهبود چشمگیر کارایی پردازنده های گرافیکی، امکان اجرای مدلهای پیچیدهتر را نیز فراهم کردهاند.

از سوی دیگر، رشد صعودی نیاز به پردازشهای سریع و کارآمد در حوزههایی نظیر هوش مصنوعی مولد (Generative AI)، پردازش زبان طبیعی (NLP) و تحلیل دادههای بزرگ، به افزایش تقاضا برای GPUهای قدرتمندتر منجر شده است. این ترکیب (تحول فناوری و نیازهای نوظهور)، اهمیت انتخاب GPU مناسب را در دنیای امروزی بیش از پیش برجسته میکند.

بیشتر بخوانید: هوش مصنوعی مولد چیست؟

بهترین GPUها برای هوش مصنوعی و یادگیری عمیق در سال 2024

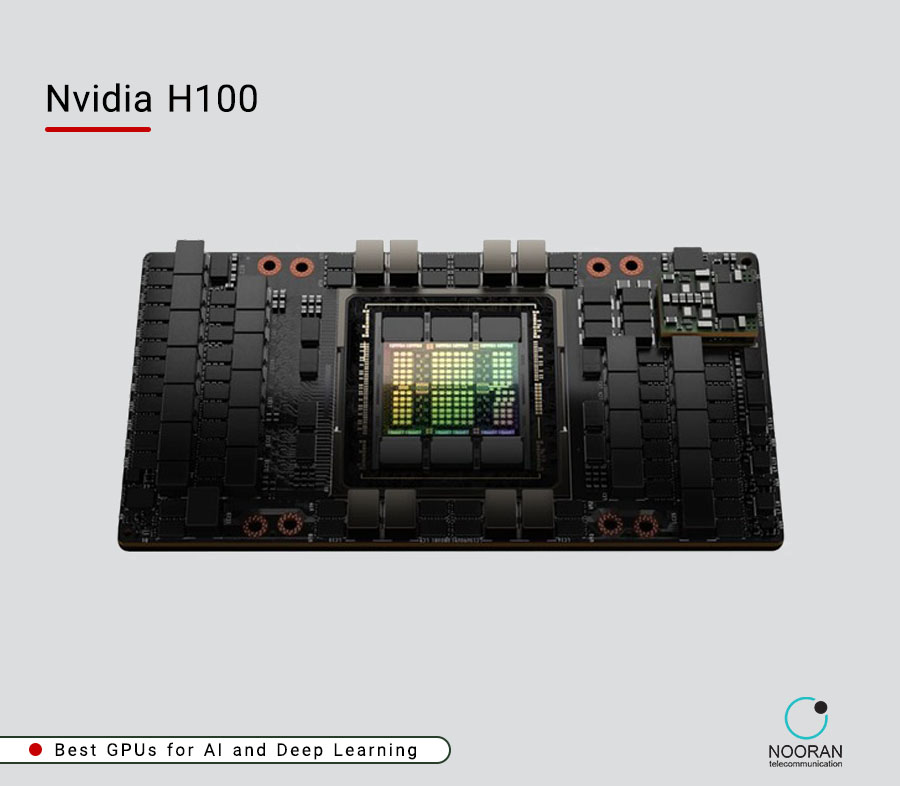

NVIDIA H100 Tensor Core GPU – انتخابی بینظیر برای پروژههای بزرگ و مراکز داده

NVIDIA H100 یکی از پیشرفتهترین GPUهای جهان به شمار میآید که به طور خاص برای مراکز داده، سازمانهای بزرگ و پروژههای هوش مصنوعی عظیم طراحی شده است. این پردازنده، با بهرهگیری از معماری نوآورانه Hopper، نه تنها استانداردهای جدیدی را در زمینه پردازش موازی و کارایی تعیین کرده، بلکه به لطف حافظه 80 گیگابایتی HBM3 و توان محاسباتی فوقالعاده بیش از 700 TFLOPS، جایگاه خود را بهعنوان یکی از قدرتمندترین GPUهای موجود تثبیت کرده است.

علاوه بر این، H100 با استفاده از فناوری پیشرفته Transformer Engine، عملکرد مدلهای یادگیری عمیق را به طرز چشمگیری بهبود بخشیده و بهویژه در حوزه هوش مصنوعی مولد (Generative AI) نقش مهمی ایفا میکند. همچنین، قابلیت Multi-Instance GPU (MIG) امکان اجرای همزمان چندین مدل یا کاربر را فراهم کرده و از کاهش عملکرد کلی جلوگیری میکند. این ویژگی منحصربهفرد، H100 را به گزینهای ایدهآل برای محیطهای چندکاربره و چندوظیفهای (multi-tasking) تبدیل کرده و کارایی آن را در پروژههای بزرگ و پیچیده تضمین میکند.

مزایا:

- توان محاسباتی بینظیر: H100 با توان بیش از 700 TFLOPS، میتواند انواع مدلهای پیچیده هوش مصنوعی و یادگیری عمیق را با سرعتی بسیار بالا اجرا کند.

- پشتیبانی از مدلهای حجیم: حافظه بزرگ HBM3 و معماری پیشرفته Hopper، این GPU را برای پروژههای عظیم یادگیری عمیق و دادههای بسیار حجیم ایدهآل کرده است.

- اجرای همزمان چند مدل: قابلیت Multi-Instance GPU این امکان را میدهد که چندین مدل را به طور همزمان اجرا کند و کارایی فوقالعادهای برای محیطهای چندکاربره ارائه دهد.

معایب:

- قیمت بالا: به دلیل قدرت پردازشی بینظیر، این GPU قیمت بالایی دارد و مناسب پروژههای کلان و مراکز داده بزرگ است.

- مصرف انرژی زیاد: H100 به یک منبع تغذیه قوی نیاز دارد و هزینههای انرژی آن نسبتاً بالاست.

NVIDIA A100 Tensor Core GPU – انتخابی قدرتمند برای پردازشهای سنگین در مراکز داده

NVIDIA A100، با بهرهگیری از معماری پیشرفته Ampere، جایگاه خود را به عنوان یکی از محبوبترین GPUها برای مراکز داده و پروژههای یادگیری عمیق تثبیت کرده است. این پردازنده، با داشتن 80 گیگابایت حافظه HBM2e، قدرت پردازشی بالا و مصرف انرژی بهینه، به گزینهای ایدهآل برای طیف گستردهای از نیازها تبدیل میشود.

علاوه بر این، قابلیت Multi-Instance GPU (MIG) امکان استفاده همزمان چندین مدل یا کاربر از یک GPU را بدون کاهش عملکرد کلی دستگاه فراهم میکند. این ویژگی منحصربهفرد، به همراه توانایی فوقالعاده این GPU در اجرای مدلهای پیچیده مانند شبکههای عصبی عمیق (DNN) و تحلیل دادههای بزرگ، A100 را به انتخابی ایدهآل برای محیطهای چندکاربره و پروژههای بزرگ تبدیل میکند.

مزایا:

- توان پردازشی بالا: A100 با توان 312 TFLOPS، برای مدلهای پیچیده یادگیری عمیق و پروژههای سنگین هوش مصنوعی بسیار مناسب است.

- مناسب برای مدلهای حجیم: حافظه بزرگ این GPU میتواند حجم بالای دادهها و مدلهای پیچیده را به راحتی پردازش کند.

- پشتیبانی از چندکاربر همزمان: قابلیت Multi-Instance GPU به این پردازنده امکان اجرای همزمان چند مدل را میدهد.

معایب:

- قیمت بالا: A100 نیز مانند H100 قیمت بالایی دارد و بیشتر برای سازمانهای بزرگ و پروژههای کلان مناسب است.

- مصرف انرژی بالا: این GPU نیز به یک منبع تغذیه قدرتمند و سیستم خنککننده مناسب نیاز دارد.

NVIDIA L40 Tensor Core GPU – گزینهای اقتصادی با توان بالا برای مراکز داده

NVIDIA L40، با بهرهگیری از معماری پیشرفته Ada Lovelace، بهعنوان یک GPU میانرده طراحی شده که تعادلی بینظیر میان عملکرد قدرتمند و قیمت مناسب ارائه میدهد. این پردازنده، مجهز به 48 گیگابایت حافظه GDDR6، گزینهای ایدهآل برای مراکز داده و پروژههایی است که علاوه بر نیاز به عملکرد بالا، بودجه محدودی نیز دارند.

همچنین پشتیبانی از CUDA و Tensor Coreها، L40 را به انتخابی مناسب برای استفاده با فریمورکهای یادگیری عمیق مانند TensorFlow و PyTorch تبدیل کرده است. این ویژگی، همراه با توانایی پردازش مدلهای یادگیری عمیق متوسط تا بزرگ، باعث شده که این GPU نه تنها در تحلیل دادهها بلکه در کاربردهای متنوعی از جمله هوش مصنوعی مولد، نیازهای کاربران مختلف را پوشش و عملکرد مثبتی از خود نشان دهد.

مزایا:

- بازدهی بالا: این GPU با حافظه گسترده و توان محاسباتی بالا، برای پردازش مدلهای یادگیری عمیق متوسط تا بزرگ انتخاب مناسبی است.

- پشتیبانی از CUDA و Tensor Coreها: سازگاری L40 با این فناوری ها آن را به گزینهای ایدهآل برای کار با کتابخانههای یادگیری عمیق مانند TensorFlow و PyTorch تبدیل میکند.

- قیمت مناسب: نسبت به مدلهای پیشرفتهتر مانند H100 و A100، برای پروژههای متوسط و مراکز داده با بودجه کمتر ایدهآل است.

معایب:

- کارایی پایینتر نسبت به مدلهای پیشرفتهتر: با وجود عملکرد بالای L40، این GPU در مقایسه با مدلهای حرفهایتر مانند H100 و A100 توانایی کمتری دارد.

NVIDIA T4 Tensor Core GPU – انتخابی کارآمد و اقتصادی برای پروژههای سبکتر

NVIDIA T4، با طراحی کم مصرف و قیمت اقتصادی، یکی از بهترین انتخابها برای پروژههای کوچکتر و سرورهای بهینه از نظر مصرف انرژی به شمار میآید.این GPU، با بهره گیری از معماری پیشرفته Turing و 16 گیگابایت حافظه GDDR6، برای محیطهایی با محدودیت منابع انرژی و پردازش مدلهای سبکتر طراحی شده است.

افزون بر این، پشتیبانی از فناوریهای پیشرفتهای مانند CUDA و Tensor Coreها، اجرای مدلهای یادگیری ماشین (Machine Learning) با دقت بالا را ممکن ساخته و این پردازنده را به گزینهای ایدهآل برای پروژههای مقرونبهصرفه و کارآمد تبدیل کرده است. این ترکیب از عملکرد بالا، صرفه جویی در انرژی و قیمت مناسب، T4 را به انتخابی هوشمندانه برای نیازهای سبکتر تبدیل میکند.

مزایا:

- قیمت مقرونبهصرفه: T4 یک گزینه اقتصادی عالی برای پروژههای سبک و مراکز داده با بودجه محدود است.

- مصرف انرژی کم: این GPU با مصرف انرژی پایین برای محیطهایی با محدودیت منابع انرژی بسیار مناسب است.

- پشتیبانی از CUDA و Tensor Coreها: با وجود اقتصادی بودن، T4 از CUDA و Tensor Coreها پشتیبانی میکند.

معایب:

- قدرت پردازشی کمتر: T4 برای پروژههای سنگین و مدلهای پیچیده به اندازه مدلهای گرانتر کارایی ندارد.

NVIDIA RTX 4090 – انتخابی قدرتمند برای کاربران حرفهای و پروژههای مستقل

NVIDIA RTX 4090 بهعنوان یکی از قدرتمندترین GPUهای موجود، گزینهای ایدهآل برای کاربران حرفهای و محققان با بودجهای محدود است که به توان پردازشی بالا برای پروژههای هوش مصنوعی و یادگیری عمیق نیاز دارند. این پردازنده گرافیکی، با بهرهگیری از معماری پیشرفته Ada Lovelace و 24 گیگابایت حافظه GDDR6X، سرعت و عملکردی استثنایی در اجرای مدلهای Deep Learning ارائه میدهد.

RTX 4090 با ارائه قابلیتهای گسترده، در حوزههایی نظیر آموزش مدلهای یادگیری عمیق، شبیهسازیهای پیشرفته و رندرینگ سهبعدی، توانسته نیازهای متنوع کاربران را برآورده کند. همچنین، پشتیبانی کامل از CUDA و Tensor Coreها سبب سازگاری آن با فریمورکهای محبوبی همچون TensorFlow و PyTorch شده که این محصول را به انتخابی فوقالعاده برای توسعهدهندگان تبدیل میکند.

این پردازنده همچنین به لطف استفاده از معماری Ada Lovelace، عملکرد بهینهای در مدیریت حرارت و مصرف انرژی ارائه میدهد. با این حال، باید در نظر داشت که مصرف انرژی آن نسبت به مدلهای سبکتر همچنان بالاست و نیازمند منبع تغذیه قوی و سیستم خنککننده مناسب است.

مزایا:

- عملکرد عالی برای Deep Learning و محاسبات پیچیده: مناسب برای پروژههای هوش مصنوعی در مقیاس کوچکتر و مستقل.

- پشتیبانی گسترده از CUDA و Tensor Coreها: قابلیت اجرای بینقص مدلهای Machine Learning و فریمورکهای محبوب.

- حافظه زیاد و سریع: با 24 گیگابایت GDDR6X، برای پردازش مدلهای یادگیری عمیق پیچیده بهخوبی عمل میکند.

- تنوع کاربردها: از هوش مصنوعی گرفته تا گرافیک و شبیه سازیهای پیشرفته.

معایب:

- هزینه نسبتاً بالا: با اینکه اقتصادیتر از GPUهای مراکز داده است، اما همچنان برای کاربران خانگی یا پروژههای کوچک پرهزینه محسوب میشود.

مصرف انرژی بالا: نیازمند منبع تغذیه قوی (حداقل 850 وات) و سیستم خنککننده کارآمد برای جلوگیری از کاهش عملکرد.

AMD Instinct MI250 – گزینهای قدرتمند برای پروژههای علمی و مراکز داده

AMD Instinct MI250، یکی از پیشرفتهترین GPUهای AMD، به لطف معماری CDNA2 و حافظه 128 گیگابایتی HBM2e، به گزینهای قدرتمند برای مراکز داده و پروژههای علمی تبدیل شده و در پردازشهای سنگین و تحلیل دادههای عظیم عملکردی بینظیر دارد.

قابلیت پردازش دقیق در FP64 و FP32، همراه با فناوریهای پیشرفته، MI250 را در شبیه سازیهای علمی و تحلیل دادههای حجیم به ابزاری قدرتمند تبدیل کرده است که نه تنها محاسبات سنگین را سریعتر انجام میدهد، بلکه گزینهای بیرقیب برای مراکز تحقیقاتی و پروژههای دولتی محسوب میشود.

از سوی دیگر، توانایی فوق العاده این پردازنده در مدیریت دادههای عظیم و دقت در انجام محاسبات پیچیده، از نقاط قوت آن به شمار میآید. با این حال، نبود پشتیبانی از CUDA میتواند در پروژههایی که نیاز به استفاده از فریمورکهایی مانند TensorFlow دارند، محدودیتی ایجاد کند؛ اما MI250 همچنان در بسیاری از پروژههای علمی و پردازشهای سنگین به عنوان یک گزینه بیرقیب شناخته میشود.

مزایا:

- حافظه با ظرفیت بالا: حافظه 128 گیگابایتی HBM2e، ایدهآل برای مدلهای عظیم و دادههای حجیم.

- توان محاسباتی بالا: عملکرد فوقالعاده برای پروژههای علمی و شبیهسازیهای پیشرفته.

- دقت در محاسبات: قابلیت پردازش با دقت FP64 و FP32، مناسب برای کاربردهای تحقیقاتی و علمی دقیق.

معایب:

- عدم پشتیبانی از CUDA: باعث میشود که استفاده از این GPU در پروژههای وابسته به فریمورکهای خاص محدود شود.

- قیمت بالا: به دلیل قابلیتهای پیشرفته، فقط برای مراکز داده و پروژههای کلان مقرونبهصرفه است.

جمعبندی و پیشنهادات نهایی

انتخاب یک GPU مناسب نقشی حیاتی در افزایش سرعت و بهبود کارایی پروژههای هوش مصنوعی و یادگیری عمیق ایفا میکند. برای پروژههای بزرگ و سنگین، NVIDIA H100 به دلیل قدرت پردازشی بالا و حافظه گسترده، گزینهای ایدهآل به شمار میآید و میتواند نیازهای پیچیده شما را به بهترین شکل برآورده کند.

برای پروژههای متوسط، NVIDIA A100 و NVIDIA L40 با ترکیبی از قدرت بالا و امکانات پیشرفته، گزینههایی کاربردی محسوب شده که در مقایسه با سایر مدلها، قیمت مناسبتری ارائه میدهند.

در مقابل، اگر نیاز شما با قدرت پردازشی کمتر برطرف میشود، NVIDIA T4 بهعنوان انتخابی اقتصادی و کممصرف میتواند گزینهای ایدهآل باشد.

در نهایت، با در نظر گرفتن نیازهای پروژه و محدودیتهای بودجه، میتوانید GPU مناسب خود را انتخاب کرده و از عملکردی بهینه بهرهمند شوید.